Comencemos con la premisa básica de que la gran mayoría de las cargas de trabajo del mundo permanecen en centros de datos privados. Los proveedores de infraestructura en la nube están trabajando arduamente para cambiar esas cargas de trabajo, pero la tecnología siempre se mueve mucho más lentamente de lo que creemos. Esa es la lente a través de la cual operan muchas empresas de la nube.

La idea de que usted opera tanto en prem como en la nube con múltiples proveedores es la idea detrás de la noción de la nube híbrida. Es donde empresas como Microsoft, IBM, Dell y Oracle están apostando. Estas empresas de empresas muertas en la lana ven a sus grandes clientes desplazarse a la nube más lentamente de lo que imagina, y desean proporcionarles las herramientas y tecnologías para administrar en ambos mundos, al tiempo que les ayudan a cambiar cuando están. Listo.

La computación nativa de la nube se desarrolló en parte para proporcionar un único tejido de administración en la nube y la nube, lo que libera a la TI de tener dos conjuntos de herramientas y de alguna manera intenta salvar la brecha entre los dos mundos.

Lo que quiere todo proveedor de nube.

Red Hat- Ya sabes, la compañía que se vendió a IBM por $ 34 mil millones esta semana - ha operado en este mundo. Si bien la mayoría de la gente piensa que la compañía es la responsable de llevar Linux a la empresa, en los últimos años, ha ayudado a los clientes a gestionar esta transición y crear aplicaciones que podrían vivir en parte en la nube y en la nube.

Como ejemplo, ha construido OpenShift, su versión de Kubernetes. Como me dijo el CEO Jim Whitehurst el año pasado, “Nuestro producto más popular es OpenShift. La gente habla de contenedores y se olvidan de que es una característica de Linux ”, dijo. Ese es un sistema operativo sobre el que Red Hat sabe una cosa o dos.

Con Red Hat en el redil , IBM puede sostener que es de código abierto; pueden construir aplicaciones modernas sobre herramientas de código abierto y ejecutarlas en la nube de IBM o cualquiera de sus competidores, un enfoque híbrido real.

Microsoft tiene una gran ventaja aquí, por supuesto, porque ya tiene una presencia masiva en la empresa. Muchas compañías podrían ser descritas como tiendas de Microsoft, y para aquellas compañías que se mudan de Microsoft a la nube, Microsoft representa un desafío menos abrumador que empezar de cero.

Oráculo trae un valor similar con sus productos de base de datos central. Las empresas que usan bases de datos Oracle, casi todos, pueden encontrar más fácil trasladar esos datos valiosos a la nube de Oracle, aunque las cifras no sugieren que eso suceda necesariamente (y Oracle ha dejado de desglosarsus ingresos en la nube).

Dell, la cual gastó $ 67 mil millones para EMC , lo que hace que la compra de Red Hat sea pálida en comparación, ha estado tratando de reunir una solución híbrida mediante la combinación de hardware VMware, Pivotal y Dell / EMC.

Informes de proveedores en la nube

Podría argumentar que el híbrido es un estado temporal, que en algún momento, la gran mayoría de las cargas de trabajo eventualmente se ejecutarán en la nube y el negocio híbrido como lo conocemos hoy en día se reducirá continuamente con el tiempo. Ciertamente estamos viendo que los ingresos de la infraestructura de la nube se disparan sin signos de desaceleración a medida que más cargas de trabajo pasan a la nube.

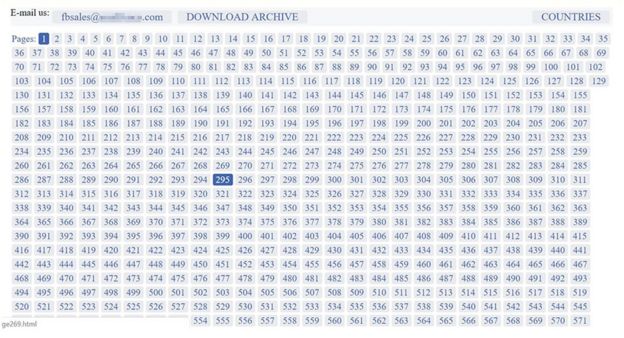

En sus últimos informes de ganancias, aquellos que rompen esas cosas, los exitosos, informaron un crecimiento en su negocio de la nube. Es importante tener en cuenta que estas empresas definen los ingresos de la nube de diferentes maneras, pero se puede ver que la tendencia es definitivamente mejor:

AWS reportó ingresos de $ 6.7 mil millones en ingresos para el trimestre, en comparación con los $ 4.58 mil millones del año anterior.

Microsoft Intelligent Cloud, que incorpora productos como Azure, productos de servidor y servicios empresariales, tenía 8.600 millones de dólares, frente a los 6.900 millones de dólares.

IBM Technology Services y Cloud Platforms, que incluyen servicios de infraestructura, servicios de soporte técnico y software de integración reportaron ingresos de $ 8,6 mil millones, frente a los $ 8,5 mil millones del año anterior. Otros como Oracle y Google no rompieron sus ingresos en la nube.

Todo esto es para decir, hay mucho dinero en la mesa aquí y las empresas están moviendo más cargas de trabajo a un ritmo cada vez más rápido. También te habrás dado cuenta de que el crecimiento de IBM es plano en comparación con los demás. Ayer, en una llamada con analistas y periodistas, el CEO de IBM, Ginni Rometty, proyectó que los ingresos para la nube híbrida (como lo define) podrían llegar a $ 1 billón para 2020. Ya sea que ese número sea exagerado o no, hay claramente una cantidad significativa de negocios aquí , e IBM podría verlo como una salida a sus problemas de ingresos, especialmente si pueden aprovechar la consultoría / servicios junto con él.

Probablemente haya tanto negocio que haya espacio para más de un ganador, pero si usted preguntara antes del domingo si IBM tenía una oportunidad en esta mezcla contra sus formidables competidores, especialmente los nacidos en la nube como AWS y Google, probablemente no lo haría. Les he dado muchas oportunidades.

Cuando Red Hat finalmente une sus fuerzas con IBM, al menos les da a sus equipos de ventas un argumento convincente, uno que podría involucrarlos en la conversación, y probablemente esa es la razón por la que estaban dispuestos a gastar tanto dinero para conseguirlo. Los vuelve a poner en el juego, y después de años de lucha, eso es algo. Y en el proceso, ha impulsado el mercado de la nube híbrida de una manera que no habíamos visto venir la semana pasada antes de este acuerdo.